Synthetische Medien schaffen auf TikTok alternative Fakten. Unter synthetische Medien oder „synthetic media” versteht man Medieninhalte, die ganz oder teilweise durch KI-Technologie erzeugt wurden oder die auf maschinellen Lernprozessen wie etwa Algorithmen basieren. Durch Bild-, Text-, Audio-, Videobearbeitungsprogramme wie ChatGPT, Pictory oder Midjourney ist es selbst für Laien einfacher denn je, hochprofessionelle Inhalte bequem per Mausklick zu produzieren. Es zeigt sich: Distribution von Desinformation kann so einfach wie noch nie erfolgen. Schon heute zirkulieren im englischsprachigen Raum auf TikTok unzählige synthetisch erzeugte Videos und Hochglanz-Deepfakes.

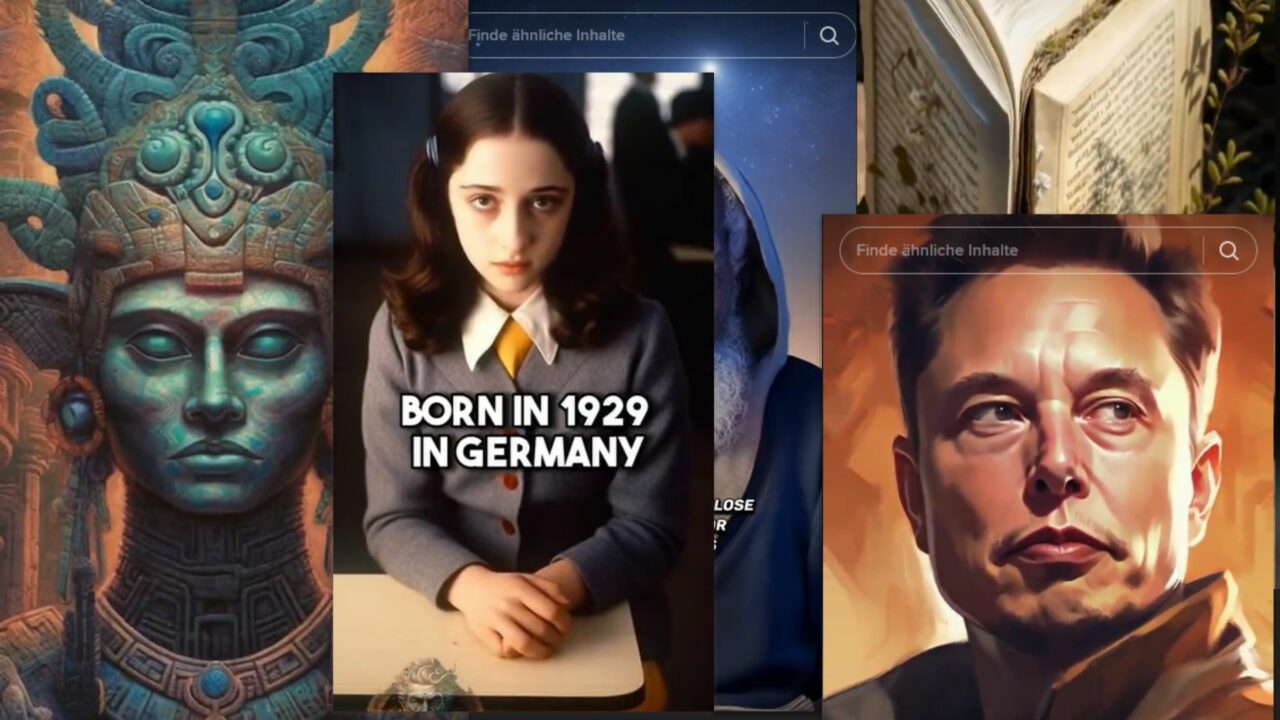

Momentan machen auf TikTok Reichweiten- und Follower-starke verschwörungsideologische Kanäle die Runden und präsentieren ihren verqueren Realitätsentwurf, mit dem Ziel, diesen Verschwörungsmentalitäten vor allem bei einer jungen Zielgruppe zu kultivieren. So verteilen ein Großteil dieser Kanäle nicht nur Inhalte in Kurzform, sondern verlinken in ihren Videos zu kostenlosen „e-Book Bundles”. Wer dahinter steckt, bleibt unklar. Dabei bestechen jedoch nicht nur die schiere Zahl, sondern auch Qualität und immersiver Charakter. Die Videos sind ästhetisch anspruchsvoll und selbst die von einer künstlichen Intelligenz vorgelesenen Textblöcke oder O-Töne klingen professionell eingesprochen. Der Großteil dieser verschwörungsideologischen Kanäle sind jedoch nicht weniger als einen Monat alt. Trotzdem verzeichnen einige zum Teil schon über 400.000 Follower*innen. Wie Pilze nach dem Regen erscheinen immer neue Inhalte und Kanäle, die vor allem junge Zuschauer*innen mit vermeintlicher Bibelexegese, Fake History (erfundene Geschichte) oder Verschwörungserzählungen überfluten. Im Schnitt erscheinen auf diesen KI-getriebenen verschwörungsideologischen Kanälen täglich zwei oder drei hochprofessionell wirkende Videos. Einfacher Zugang trifft auf ästhetischen Anspruch und gute Dramaturgi

Stalin, Marx und Jesus machen TikTok Reels

Ein nüchtern wirkender Ronald Reagan spricht junge Zuschauer*innen direkt an, lächelt und erzählt seine Lebensgeschichte in unter zwei Minuten. In schneller Abfolge werden wichtige Stationen aus dem Leben des republikanischen Ex-Präsidenten nachgezeichnet. Die Lebensgeschichte erzählt sich quasi von selbst, doch wer sich nicht mit dem Leben des kontroversen Politikers auskennt, verpasst auch den desinformierenden Aspekt des Inhaltes. Das Video arbeitet nämlich mit starken Verkürzungen, verfolgt einen dramatischen Bogen und kondensiert reale Begebenheiten in Mini-Heldenreisen, die sich optimal für den schnellen digitalen Verzehr eignen.

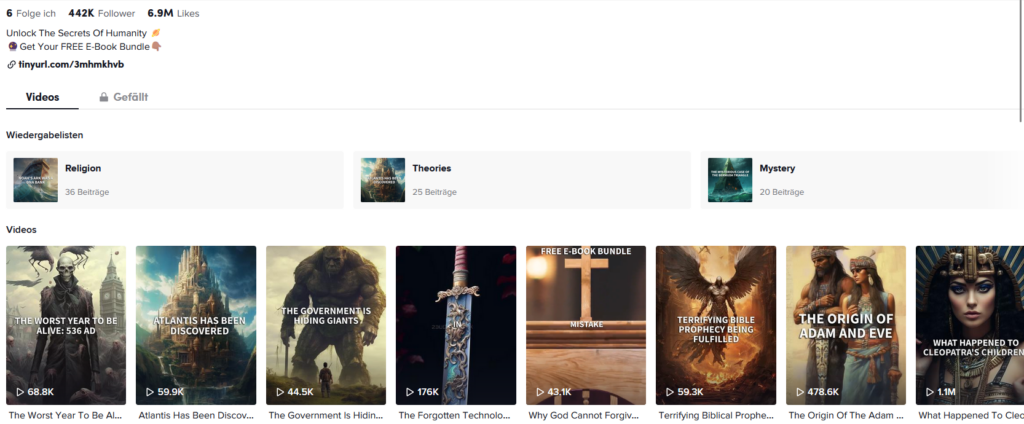

Eine reale Biografie können die Videos nicht ersetzen. Das wollen sie aber auch nicht. Ihr Primärziel lautet Reichweite durch „Snackable History” oder sogenannte Geschichtshäppchen. Quadratisch-praktisch-gut wird dann über das Leben des Drogen-Barons Pablo Escobar, über Anne Frank oder auch mythische Figuren berichtet. Vor allem bei dem Video zu Anne Frank wird der Betrachter*in schnell mulmig, da die Stimme der synthetisch erzeugten Anne von einer Baby-Stimme eingesprochen wird.

Das Portfolio solcher KI-Erzeugnisse umfasst jedoch weitaus mehr als nur sprechende historische Figuren mit desinformierenden Soundbytes. Die weitaus populäreren Kanäle arbeiten nämlich lieber mit frei erfundenen Inhalten und setzen direkt auf Verschwörungserzählungen, um Viralität zu erzeugen.

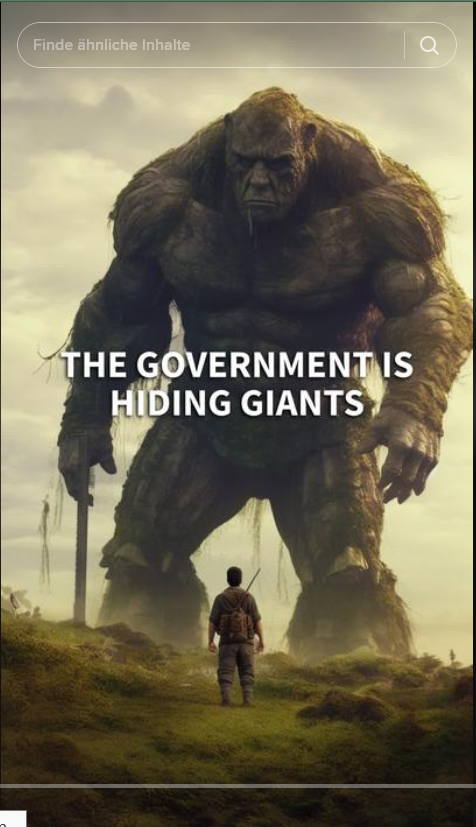

Ganze Kanäle widmen sich vermeintlichen „Verschwörungen” und berichten über Alien-Wesen wie die „Anunnaki” oder gefallene Engel („Nephilim”), sprechen über die geheimen Pläne Satans oder spekulieren über skurrile Geheimakten. So zum Beispiel lautet in einem Video die Überschrift „Die Regierung versteckt Riesen” und in einer Minute soll bewiesen werden, dass Riesen real existieren und von den Behörden geheim gehalten werden. Verschiedene KI-Bilder von vermeintlichen Ausgrabungsstätten dienen dabei als „Beweismaterial”. Diese sollen Faktizität und Authentizität vorgaukeln, insbesondere bei Menschen mit wenig Medienkompetenz.

Auch wenn diese Beispiele harmlos erscheinen, verstärken sie eine institutionelle Skepsis und können falsche Informationen oder Verschwörungserzählungen in einer jungen Altersgruppe normalisieren. Die Gefahr ist, dass Zuschauer*innen die desinformierenden Aspekte verharmlosend betrachten oder gar nicht erst verstehen, was zu einer Anfälligkeit für Desinformation führen könnte. So berichtet auch WIRED über die Gefahren, die als Folge von KI-generierter Desinformation entstehen können und zitiert Professor Michael Graziano von der Princeton University, der eine „Post-Wahrheits-Welt“ als Folge von KI-bezogener Desinformation befürchtet. Ihm nach würden Menschen dadurch viel leichter Opfer von falschen Erzählungen werden.

Auch menschenfeindliche Inhalte könnten sich mithilfe von KI und synthetischer Medien viel leichter einschleusen und normalisieren. WIRED schreibt auch über Alien-Videos, die von Anunnaki – einer allmächtigen außerirdischen Rasse handeln. Diese im Verborgenen agierenden Eliten können auch als antisemitische Chiffre fungieren, die vor allem bei Menschen mit einem Hang zu Verschwörungsmentalitäten Ressentiments potenzieren könnten.

Neurechte und die Künstliche Intelligenz

Auch in Deutschland ermöglicht Generative KI es, antidemokratischen Akteur*innen, alternative Wirklichkeitsentwürfe zu implementieren. So nutzt auch Simon Kauperts neurechte Medienproduktionsfirma „Filmkunstkollektiv”, das Open AI Tool Midjourney, um ihre Filmbeiträge anzureichern. Auf ihrer Twitter-Seite präsentiert das neurechte Projekt ihre ersten KI-generierten Bildergebnisse als Thread. Dies könnte reaktionären Kräften in Zukunft ganz andere ästhetische Mittel an die Hand geben, mit denen sie ihre metapolitische Strategie der Diskursunterwanderung verfolgen könnten. Neurechte Ideologie versteht nämlich unter metapolitischer Unterwanderung auch die Eroberung des vorpolitischen Raumes, durch die Zersetzung des demokratischen Diskurses. Ganze Kanäle, aber auch Filme ließen sich so mittels generativer KI in kürzester Zeit produzieren.

Das sind beängstigende Aussichten, vor allem, wenn man bedenkt, dass die Präventionsmaßnahmen zur Identifizierung und Kennzeichnung von KI-generierten Inhalten bislang auch seitens der Content-Moderationssysteme und Behörden völlig unzureichend bis komplett inexistent sind.