Lässt ein Social Media-Unternehmen rechtsextreme Akteur:innen auf ihrem Netzwerk agieren, können sie Accounts und Seiten errichten, Werbung schalten, vielleicht sogar unter die Monetarisierung fallen – also Geld aus Werbeanzeigen verdienen. Das hat gesellschaftlich wenig wünschenswerte Effekte: Einerseits können Neonazis ihre menschenverachtende Ideologie verbreiten und Andersdenkende einschüchtern– andererseits sind nicht-recht User:innen und Werbekund:innen unglücklich, wenn sie rassistischen oder antisemitischen Hass auf der Plattform in Berührung kommen.

Kein Wunder also, das viele der großen Sozialen Netzwerke sich in die Community Guidelines schreiben, dass Beschimpfungen, Hass und gruppenbezogene Menschenfeindlichkeit bei ihnen nicht erlaubt sind – und zentrale rechtsextreme Akteur:innen, die sich auf der Plattform gefährlich benehmen, deplatformen, also sie verbannen und der Plattform verweisen. Diese Akteur:innen haben dann etwa strafbare Inhalte gepostet, sich zu koordinierten Attacken gegen andere verabredet, verbotene Organisationen unterstützt oder massiv gefährliche Desinformationen verbreitet.

Warum bleiben Neonazis auf Facebook oder YouTube?

Der neue Bericht des Counter Extremism Projekts, „Wo Wölfe Kreide fressen – Die rechtsextreme Infrastruktur auf Facebook, Instagram, YouTube und Twitter“, der Ende Oktober veröffentlicht wird und Belltower.News vorab vorliegt, wendet sich einer weiteren Volte zu:

Offen rechtsextreme Akteur:innen, die auf großen Plattformen aktiv sind, sich dort aber nicht problematisch benehmen.

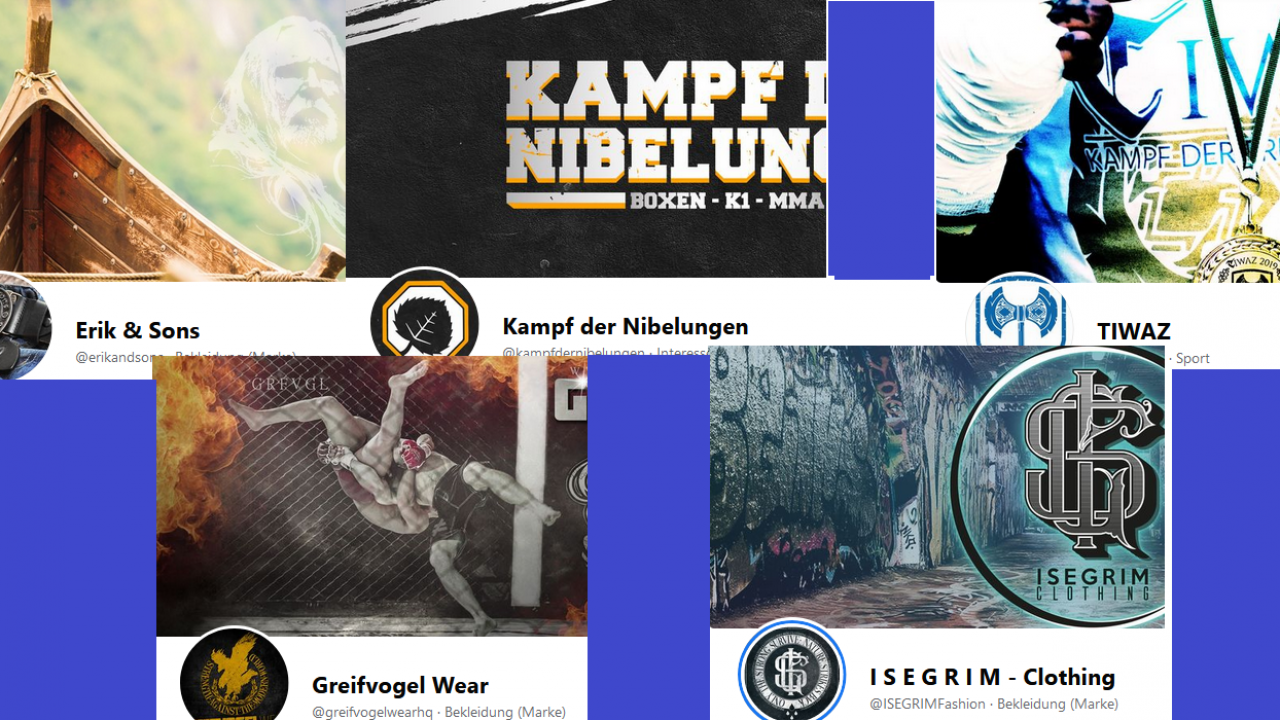

Der Bericht findet neonazistische, zum Teil gewaltorientierte deutsche Schlüsselakteur:innen wie Tommy Frenck (NPD, Neonazi, Konzertveranstalter, Gastronom), Patrick Schröder (NPD, Neonazi, YouTuber mit „FSN TV“, Bekleidungshersteller mit „Erik & Sons“) oder Alexander Deptolla (Neonazi, Kampf der Nibelungen) mit diversen Präsenzen auf Facebook (54 Profile, 39 Akteur:innen, insgesamt rund 260.000 Abonnent:innen), Instagram (37 Profile, 34 Akteur:innen, insgesamt über 80.000 Follower:innen), YouTube (33 Profile, 27 Akteur:innen, insgesamt 9,5 Mio. Views) und Twitter (17 Profile, 16 Akteur:innen, insgesamt rund 6.800 Follower:innen).

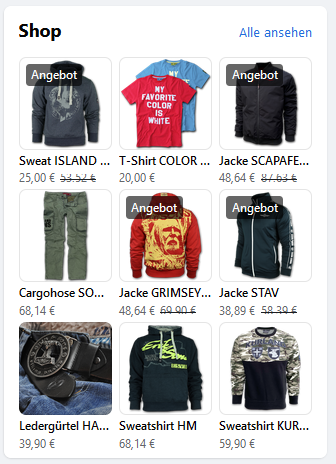

Die Follower-Zahlen zeigen: Die Vernetzung läuft und damit einher geht die Verbreitung und Normalisierung von rechtsextremem Lifestyle. Aber: Die explizite Agitation, die rassistischen, antisemitischen und islamfeindlichen Ausfälle der Neonazis, die finden nicht auf diesen Plattformen statt – oder nur als „Dog Whistles“, also als Andeutungen, die weder justiziabel sind noch bisher von den Plattformen geahndet werden. Sie dienen allerdings trotzdem der Feier und der Selbstvergewisserung des eigenen rechtsextremen Lifestyles. Hauptsächlich allerdings nutzen die Neonazis vor allem Facebook und Instagram zum Geldverdienen. Sie preisen ihre Versandhandel oder Veranstaltungen an, benehmen sich dabei den Community-Guidelines entsprechend, sie bedrohen andere Menschen auch nicht durch konkrete Postings. Trotzdem fühlen sich nicht wenige User:innen allein durch die Präsenz von Neonazis in großen Sozialen Netzwerken bedroht. Zumindest lässt es sie an der Ernsthaftigkeit zweifeln, wenn Soziale Netzwerke angeben, sich gegen Abwertung und Diskriminierung online zu engagieren.

Alexander Deptollas „Kampf der Nibelungen“ hat auch einen Shop mit T-Shirts zu „Blut“ und „Kämpfen“ für Männer, Frauen „und für die Kleinsten“ – für boxende Junges und Mädchen mit Zöpfen, ein „Dog Whistle“-Code in der rechtsextremen Szene.

Welche Gegenstrategien sind möglich?

Auch das Counter Extremism Project sieht die Neonazis auf der Plattform als Problem für Verhalten und Glaubwürdigkeit der Social Media Plattformen an: Studienautor Alexander Ritzmann regt an, nicht mehr nur auf das potenziell gefährliche Verhalten der Neonazis auf der Plattform und auf rechtliche Fragen zu blicken, sondern fordert Unternehmen auf, auch über ihre Werteorientierung nachzudenken und entsprechend zu handeln. Denn es ist erwiesen, dass die rechtsextreme Online-Strategie des führerlosen Aktivismus gerade auch so funktioniert, dass nicht unbedingt die bekannten Akteur:innen selbst gewalttätig werden, aber mit ihren kontinuierlichen Posts andere motivieren, dies vor Ort zu tun. Könnte man also schädliches Verhalten auch außerhalb der einzelnen Plattform einbeziehen? Ließen sich gar gefährliche Weltanschauungen ausschließen?

Außerdem diskutiert der Report, ob User:innen eigentlich Soziale Netzwerke verklagen könnten, ihre Community Standards selbst einzuhalten, und ob das Haftungsprivileg noch zeitgemäß ist, dass Soziale Netzwerke von einer strafrechtlichen Haftung für die Inhalte entbindet, die über die Plattformen gepostet werden. Denn wenn Unternehmen haften, werden sie damit automatische motiviert, für eine sichere Umgebung auf der Plattform für ihre Nutzer:innen zu sorgen.

Juristisch: Ein weites Feld

Es ist eine Qualität des Reports, dass diese Fragen aufgeworfen werden, aber sie bleiben nicht unkommentiert stehen. In einem Interview ordnet Dr. Daniel Holznagel, als in der Materie erfahrener Jurist, die angeregten Ideen ein. Dabei wird klar: Zu vielen dieser Fragen gibt es juristisch noch keine Antworten, weil es noch keine Präzedenzfälle gab. Es hat noch niemand ein Netzwerk auf die Einhaltung der eigenen Community Standards verklagt. Die Aufhebung des Haftungsprivilegs, ursprünglich zur Unterstützung der jungen, damals noch nicht riesigen und milliardenschweren, Netzwerke gedacht, wurde bisher weder in den Debatten zum Netzwerkdurchsetzungsgesetz in Deutschland noch zum Digital Services Act (DSA) auf europäischer Ebene thematisiert. Diese Debatte beginnt erst dieser Tage in den USA.

Und selbst, wenn es um das „digitale Hausrecht“ der Unternehmen geht – also die Frage, was Plattformen einschränken dürfen und was nicht -, ist vieles weiterhin „Neuland“. Dies zeigen unter anderem die Fälle in Deutschland, in denen Netzwerke Beiträge entfernt haben, weil sie gegen Community Standards verstießen, und später nach Gerichtsentscheidungen gezwungen wurden, die problematischen Inhalte wieder hochzuladen, weil der Autor sie dazu gerichtlich zwingen konnte.

Bisher dürfen Sperrungen nur nach Abmahnungen und mit „wichtigem“ bzw. „sachlichem“ Grund vorgenommen werden. Diese sind allerdings kaum definiert. Ist das wiederholte Posten von Hassrede ein Grund? Ist es die Verbreitung antidemokratischer Propaganda, auch wenn sie vor allem durch Bilder und Andeutungen geschieht? Fällt das unter die „Vertragsverstöße“, die eine Kündigung rechtfertigen?

Selbst die Frage, ob es rechtlich zulässig wäre, eine:n Nutzer:in wegen radikaler Weltanschauung oder gewaltorientiertem Offline-Verhalten zu sperren, ist noch ungeklärt. Natürlich würden entsprechende Regeln weitere Fragen nach sich ziehen. Wie willkürfrei sind solche Entscheidungen möglich? In einer Demokratie – aber auch in weniger demokratisch regierten Ländern, in denen die Netzwerke ebenfalls operieren? Reicht es, Schaden in der Offline-Welt verhindern zu wollen? Ab wie viel problematischen Personen ist eine Organisation eine Hassorganisation?

Klärung bringen könnten an dieser Stelle staatliche Regulierung oder Vorgaben – oder auch behördliche Anordnung von Account-Sperren zum Beispiel im Fall von digitalen Straftaten. Doch dies geschieht bisher kaum. Zivilgesellschaftliche Nutzer:innen können also nur weiter fordern, dass sie sich eine möglichst gefährdungsarme und diskriminierugnsfreie Online-Umgebung wünschen und gegebenenfalls Konsequenzen ziehen, wenn diese nicht gewährleistet wird – oder die ausstehenden Klagen auf den Weg bringen.